NVIDIA 刚刚给自动驾驶赛道投下了一枚重磅炸弹。2026 年 1 月 5 日,NVIDIA 正式发布了 Alpamayo。这不仅仅是一个单纯的感知模型,而是一个旨在赋予自动驾驶汽车“思考”与“解释”能力的开放生态系统——而这正是目前行业最稀缺的拼图。CEO Jensen Huang 将其定义为“物理 AI 的 ChatGPT 时刻”,意在帮助车辆从容应对那些罕见且复杂的极端路况(Corner Cases)。

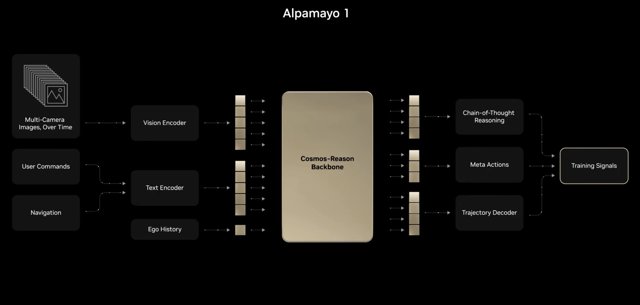

首发阵容中的核心是 Alpamayo 1,这是一个强大的视觉-语言-行动模型(VLAM)。通俗点说,它能将车辆“看到”的画面与语言理解能力相结合,从而决定“怎么做”。最硬核的地方在于,它能生成“显式推理逻辑链”——这意味着如果车子为了躲避一个乱窜的购物车而突然转向,它能清清楚楚地告诉你为什么要这么做。为了喂饱这个 AI,NVIDIA 还同步推出了 Physical AI dataset,这套海量数据库包含了来自全球 2500 多个城市的 30 多万段真实驾驶视频。

为什么这很重要?

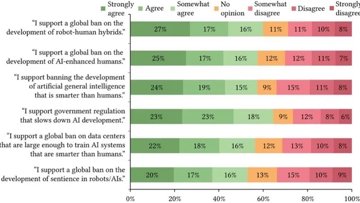

多年来,自动驾驶行业与公众之间一直处于一种微妙的“信任博弈”中。那些像“黑盒”一样难以捉摸、无法解释决策逻辑的模型,很难真正赢得用户的信任。通过力推可解释 AI(XAI),让车辆能够“开口说话”解释决策过程,NVIDIA 正在正面硬刚这个信任难题。这种从“感知驱动”向“推理驱动”的转变,是突破 L3 级瓶颈、真正实现 L4 级自动驾驶(即车辆在大多数情况下无需人类干预)的关键一步,甚至可以说是必经之路。未来的车不仅要“看清”路,更要真正“读懂”路。