在机器人世界迎来一项重磅举措:**北京人形机器人创新中心(X-Humanoid)**已正式开源其XR-1模型。这可不是那种随便扔到GitHub上的又一个算法;XR-1是首个通过中国国家具身AI标准的视觉-语言-动作(VLA)模型,这项标准旨在将机器人从实验室里的“稀奇玩意儿”推向真正实用的机器。本次发布包括XR-1模型、全面的RoboMIND 2.0数据集以及用于模拟的高保真数字资产库ArtVIP。

从本质上讲,XR-1旨在打破困扰大多数机器人、让它们笨手笨脚、摸不着头脑的“感知-行动”障碍。它采用了其创造者所称的统一视觉-运动代码(UVMC),这项技术在机器人“所见”与“所动”之间建立了一种共通的语言。这使得机器人能够做出“本能”反应,比如当有人挪动杯子时,立刻停止倾倒。得益于三阶段训练过程,该模型能够将其技能泛化到各种截然不同的机器人本体上,无论是双臂的Franka系统,还是X-Humanoid自家的**天工(Tien Kung)**系列人形机器人,都能游刃有余。

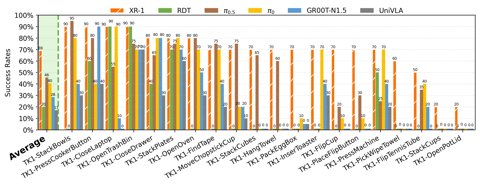

这可不仅仅是纸上谈兵的理论实力。X-Humanoid已展示了XR-1自主穿越五种不同类型的门、进行精确工业分拣,甚至在康明斯(Cummins)工厂执行重型搬运任务的能力。为此提供强大支撑的是RoboMIND 2.0数据集,它现已包含超过30万条任务轨迹,以及ArtVIP数字孪生资产。该团队声称,将这些模拟数据融入训练,能将真实世界的任务成功率提升超过25%。

为什么这很重要?

通过不仅仅开源一个模型,而是整个数据和模拟资产生态系统,X-Humanoid正在下一盘精妙的棋,旨在标准化实用自主机器人的开发。免费发布首个获得国家认证的具身AI模型,这无疑是直接尝试构建一个基础平台,有望降低入门门槛,并加速整个领域的发展。这标志着一项战略性努力,旨在超越各自为营的学术项目,为构建那些真正、最终能“搞定事情”的机器人,创造一片共同天地。